计算机软件数据处理服务 数字化时代的核心引擎

在当今信息爆炸的时代,数据已成为驱动社会发展的关键资源。而计算机软件数据处理服务,则如同一个精密高效的大脑,对海量数据进行采集、存储、分析、转化与呈现,为各行各业提供决策支持与智能化解决方案。

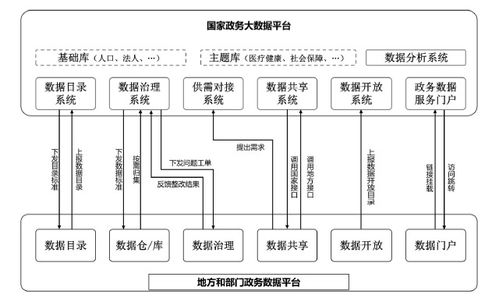

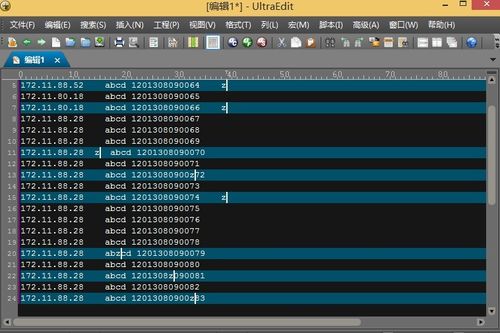

数据处理服务首先从数据采集与整合开始。通过各种接口、传感器、日志记录等方式,软件系统将来自不同源头、不同格式的结构化与非结构化数据汇聚到一起,并进行清洗、去重与标准化处理,为后续分析奠定高质量的数据基础。这一过程确保了数据的完整性与一致性,避免了“垃圾进、垃圾出”的困境。

随后是数据的存储与管理。面对TB甚至PB级别的数据量,传统存储方式已力不从心。现代数据处理服务依托数据库管理系统(如关系型数据库MySQL、非关系型数据库MongoDB)、数据仓库(如Amazon Redshift)以及分布式文件系统(如Hadoop HDFS),实现了数据的安全、可靠与高效存储。这些技术不仅保障了数据不丢失、不损坏,还能通过索引、分区等手段实现快速检索与访问。

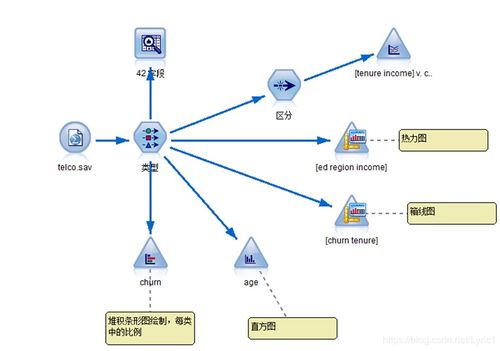

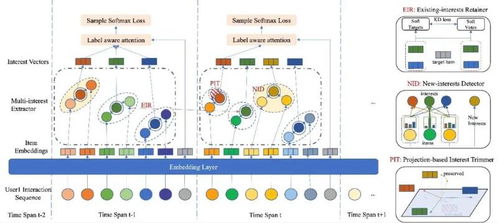

核心环节在于数据分析与挖掘。通过运用统计分析、机器学习、人工智能等算法,数据处理服务能够从看似杂乱的数据中发现规律、趋势和关联。例如,在商业智能(BI)领域,它可以帮助企业分析销售趋势、用户行为,优化营销策略;在科学研究中,它能处理实验数据,加速新发现;在公共安全领域,可协助进行模式识别与预测预警。这一过程将原始数据转化为有价值的“信息”与“知识”。

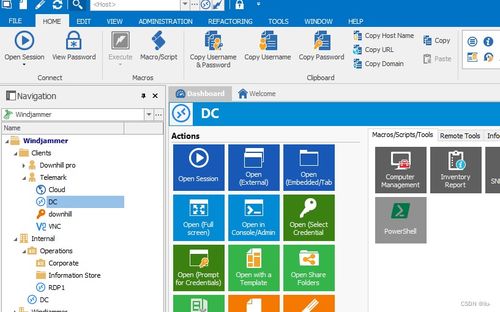

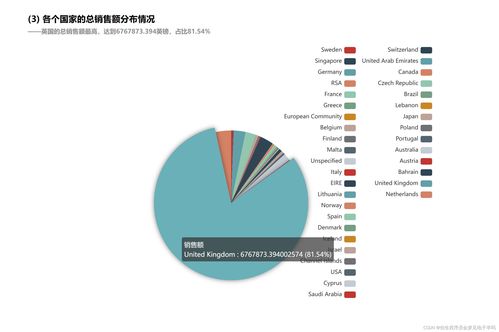

数据处理服务的输出形式多样且贴近需求。它可以通过数据可视化工具(如图表、仪表盘)将复杂结果直观呈现,辅助管理者一目了然地掌握状况;也能通过API接口将处理结果实时传递给其他应用系统,驱动自动化流程;或生成详尽的报告,为战略规划提供依据。

随着云计算、边缘计算和物联网技术的发展,数据处理服务正变得更加实时、智能与分布式。实时流处理技术(如Apache Kafka、Flink)使得对即时数据的分析成为可能,支持毫秒级的决策响应;而AI的融入则让数据处理从被动分析走向主动预测与自主优化。

这一领域也面临挑战,包括数据隐私与安全保护、处理过程的能耗问题、以及对复合型人才的需求。计算机软件数据处理服务将继续演进,在确保安全、合规与绿色的前提下,更深层次地释放数据潜能,成为推动数字化转型与智能化升级不可或缺的核心引擎。

如若转载,请注明出处:http://www.bhlmshop.com/product/57.html

更新时间:2026-02-24 06:11:11